・AI(人工知能)の科学

【目次】

(1) 進化し続けるAI

最近、メディアを賑わすことが多い「AI」。「AI」は「Artificial Intelligence」の略です。一般的な和訳は「人工知能」で、「人間の知的営みをコンピューターに行わせるための技術」、または「人間の知的営みを行うことができるコンピューターシステム」のことです。家庭内でも、部屋の形状を認識しながら作業をこなす掃除ロボットや、在庫から調理可能なレシピを提案するAI冷蔵庫など、これまで想像も付かなかったような製品が、次々と登場しています。このAIの最大の特徴として、「機械学習」ができることがあげられます。機械学習とは、「コンピューターが実社会やウェブ上に存在する膨大なデータを解析し、ビジネスなどに役立つパターンを抽出していく」能力のことです。人間のように自分で必要な事柄を学び、成長できる能力と言い換えてもいいでしょう。昨今、話題に上がることが多くなった「ディープラーニング(深層学習)」も、機械学習の研究成果の1つです。

1980年代では、中学校の試験問題を解く程度だったAIも、近年では性能の向上が著しく、2011年には、アメリカのIBM社が開発したAI「Watson」が、アメリカの人気クイズ番組「Jeopardy!」に出場して、チャンピオン2人を破ってニュースになりました。その後、AI「Watson」は、みずほ銀行のコールセンターや東京大学の医科学研究所に導入されました。さらに、アメリカの通信社では、AI「Wordsmith」という文章作成ソフトが自動で記事を書き、日本の国立情報学研究所でも、東大入試にチャレンジするAI「東ロボくん」などが続々と開発されています。2022年11月に米Open AIが公開したChatGPTは、まるで人間のように自然な対話で質問に答えられるAIとして、世界中で話題になっています。このように縦横無尽に進化し続けるAIは、今後も人類の生活や仕事の利便性を飛躍的に高めてくれることでしょう。

図.1 クイズ番組に出演し、チャンピオンに勝利したIBM社のAI「Watson」

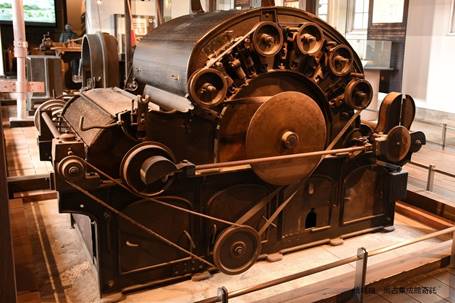

AIの発展を知るための指標として、ボードゲームにおける「人間vs.AI」があります。ボードゲームをするAIの歴史は古く、最初に思考実験が行われたのが1840年代、ゲームAIが初めて誕生したのが1912年でした。スペインの技術者であるレオナルド・トーレス・ケベードが制作したチェス用機械「El Ajedrecista」が、史上初のゲームAIとされています。AIの性能が低かった時代は、ルール通りに駒を動かすことはできても、なかなか人間相手に満足ゆく対戦を実現するのは難しく、こと強者と互するには至らない時代が長く続きます。そうした状況が大きく変わったのが、1990年代に入ってからのことです。1992年、当時のチェス世界チャンピオンで「史上最強」ともいわれたガルリ・カスパロフは、カーネギーメロン大学が開発したAI「Deep Thought」と対戦して勝利を収め、「人間がチェスでAIに負けることなどありえない」と一笑に付しました。しかし、それからわずか5年後の1997年には、アメリカのIBM社が開発したAI「Deep Blue」との勝負に敗れました。勝負は6番勝負として行われ、1勝2敗3分でカスパロフが敗北したのです。

図.2 敗戦後、カスパロフは再戦を希望したが、IBM社側がプロジェクトを終了させたため、実現しなかった

日本では、将棋のプロ棋士と将棋AIが対戦する「将棋電王戦」が2010年に始まり、今やAIとの対決は1つのイベントとして、広く認知されるようになっています。ちなみに、2015年に行われた「将棋電王戦FINAL」では、カスパロフがゲストとして招かれ、先手後手を決める振り駒を行っています。その際、カスパロフは「AIが人間を超えることは必然」とコメントしています。また、ゲームAIで対応するのが難しいといわれていた囲碁でも、2016年3月にGoogle社の子会社であるDeepMind社が開発した「AlphaGo」というゲームAIが、「世界最強の棋士」といわれるイ・セドル九段を4勝1敗で下したことが、衝撃を持って報じられました。すでにチェスや将棋で、人間のプロ相手に勝利を収めていたAIも、打ち手が複雑な囲碁で勝利するには、もう少し時間がかかるだろうと考えられていました。そして、2016年12月には、「Master」と名乗る謎のアカウントが、インターネット上の囲碁サイト「東洋囲碁」に突如現れ、世界各国のプロ棋士と60回対戦し、全戦全勝したといいます。当初はあまりの強さから、人気漫画「ヒカルの碁」の登場人物である藤原佐為ではないか、などと取り沙汰されていましたが、2017年1月にGoogle社が、自社が開発した「AlphaGo」の進化型であることを公表しました。それでは、そもそもなぜゲームAIが人間に勝つことが難しいと考えられていたのか、また、なぜ最近になって人間に勝てるようになってきたのか、簡単に説明していきましょう。

図.3 将棋AI「Ponanza」は、2017年に現役名人の佐藤天彦に勝利を収めた

ゲームAIでの対応の難しさ、それは「指し手の膨大さ」に直結します。盤面の数やゲーム性によって、指し手の数は大きく変わってくることは、言うまでもありません。オセロは盤面が8×8で自分の色で相手の石を挟むというゲーム性、チェスは盤面が8×8で6種16個の駒を用いて相手のキングを追い詰めるゲーム性、将棋は盤面が9×9で8種20個の駒を用いて相手の王将を追い詰めるゲーム性、囲碁は19×19の盤面で自分の色の領地をいかに広く確保するかというゲーム性です。さらに、チェスと将棋では、「取った相手の駒を自分の駒として使えるか否か」などといった細かいルールが加わります。以上の違いから、オセロが1028、チェスが1050、将棋が1071、囲碁が10160という種類の盤面のパターンが存在することになります。さらに、相手の行動によって、状況が様々に変化することを考え合わせると、総当たりパターンは、オセロが1058、チェスが10123、将棋が10226、囲碁が10400という、まさに天文学的数値になるのです。このように要素の数が多くなると、その組み合わせによって急激に指し手の数が増大することを、「組み合わせ爆発」といいます。また、この総当たりパターンのことを、「ゲーム木」といいます。

図.4 ゲーム毎に大幅に異なる「ゲーム木」

ゲームAIが強い相手に勝つためには、「場面場面における最適手」を見つけ出すということになるのですが、総当たり的手法では、組み合わせ爆発による天文学的数値の前では手も足も出ません。「スーパーコンピューターなら天文学的数値であろうと、総当たり的手法に対応できるのではないか」と思う人もいるかもしれません。しかし、スーパーコンピューターに使われているパーツは、私たちが普段使っているパソコンのものと、それほど差がある訳ではありません。スーパーコンピューターで行っているのは、大量のパソコンによる並列計算であり、画期的なアルゴリズムがある訳ではありません。スーパーコンピューターは、普通のコンピューターよりも、「計算速度がかなり速い」というだけなのです。それ故、スーパーコンピューターを用いたとしても、総当たり的手法では、人間のプロ相手に勝つことはできません。しかし、人間は経験や思考によって、瞬時に「これはないな」という悪手を排除可能なので、検討するパターンを一気に絞り込めます。ゲームAIが人間に勝利するためには、この「絞り込み」のアルゴリズムが必要だったのです。

それでは、なぜ最近のゲームAIは、人間を下せるようになってきたのでしょうか?あまりに膨大な数字の前には、いかにスーパーコンピューターといえども、対応は不可能です。単純にコンピューターの性能を上げるというアプローチでは、人間に勝つことはできません。そこで、1つの手法として、「モンテカルロ木探索」というものがあります。簡単に説明すると、「ランダムに指し手を広げていって、勝率の高そうな手だけを拾って集める」という方法です。「この手はない」という絞り込みを行い、次に採用すべき手の優先度を計算します。ゲーム木の概念でいうと、枝を広げていき、あり得ない枝を切り落としていく訳です。モンテカルロ木探索では、「ゲーム木の剪定」を行っていると言うべきでしょうか。このようなアルゴリズムによって、最近のゲームAIは、場面場面で最適手を選択できるようになってきたのです。

図.5 「モンテカルロ木探索」のイメージ

また、人間が過去の対局データを分析して、経験値を蓄え強くなっていくように、ゲームAIにも「過去の対局データを学ばせる」という手法が編み出されています。これが「機械学習」です。過去の対局データをインプットすることで、ゲームAIも「こういう手が来たらこう返すのがいいのか」ということを学んでいき、検討するに値しない選択肢を排除できる訳です。過去の対局データというのも膨大な数ですが、ゲーム木に比べれば微々たるものです。今や、人間はノートパソコン程度のスペックのゲームAIにも、敗北を喫するようになってきてしまいました。近年のゲームAIの急速な発展には、この機械学習が大きく関わっています。

(2) 機械学習とは?

「機械学習」とは、人間が自然に行っている学習能力と同様の機能を、コンピューターで実現しようとする統計的な方法論です。例えば、AIに「イチゴ」を理解させようとするとき、イチゴには様々な特徴(円錐に近い形、色は赤、表面に細かい凹凸、光を当てると艶やかに光るなど)があります。しかし、実際のイチゴは、必ずしも円錐形ではないし、十分に熟していなくて、赤みの薄いイチゴもあります。人間は、それらを様々な経験から総合的に判断して、イチゴであるかどうかを極めて柔軟に判断しています。イチゴをイチゴと認識するまでに、100万個のイチゴを見る必要がある子供はいません。せいぜい10個ぐらい見れば、イチゴが分かるようになります。しかし、AIには、この柔軟性はなかなか真似できません。柔軟性のないAIに、「人間並みの物体検出性能」を持たせるために必要なもの――それが「ビッグデータ」です。その量は課題にもよりますが、実用を考えた精度を求めると、最低でも104、場合によっては108というオーダーの量になります。

図. 6 「機械学習」でAIに「イチゴ」を理解させる

まずは、様々な画像を大量に集めます。そこには、イチゴの画像も大量に含まれていなければなりません。そうでなければ、画像全体の中のイチゴの「統計」を取ることができないからです。ここは重要なポイントです。全体のデータだけでなく、検出したい物体のサンプルも大量に必要になるのです。そうでないと、「統計」は上手く働きません。そして次に、AIにイチゴを教えます。そのために、AIに「これがイチゴだよ」と教えるデータを作ります。これを「教師データ」といいます。どの画像に何が写っているか、ラベルを付けたものが教師データです。つまり、イチゴが写っている画像すべてに、「イチゴ」というラベルを付ける訳です。画像には、様々な物が写っている場合が多いので、画像のどの部分に何が写っているかも含めて、ラベルを付けます。教師データは、基本的には人間が作ります。そのため、教師データを大量に作るには、とてつもない労力と資金が必要です。精度を求めるには、104というオーダーの量のデータが必要だからです。

デジタルの世界では、画像も「どの位置に、どの色が、どの輝度で写っているか」を(0, 1)で表現します。すると、膨大な(0, 1)の列ができます。これを「ピクセル値行列」といいます。その上下左右関係から、どんな要素が写っているかを把握します。種と実の色や輝度のコントラスト、種からできる影など、できる限りの特徴を検出し、それがイチゴであるとあると判断する上でどれほど重要な要素であるかを、イチゴが写っているデータとそうでないデータから数値化します。それぞれの特徴に「重み」を付けるのです。例えば、「実の赤さと緑のヘタとのコントラストの重みは0.7で、種と実のコントラストは0.5」という具合です。重みを調整していく過程を「学習」と呼びます。機械学習では、AIが与えられたデータを繰り返し学習することで、そのデータの中にあるパターンや経験則、その重要度を自律的に認識します。特に画像は、部品である特徴量の足し算で表現することができます。つまり、特徴量の総和が大きければ大きいほど、「イチゴらしさ度」が高まるので、ある基準を超えたときに「イチゴ」と判断すれば、大体当たるようになるのです。

大切なのは、「特徴量をどのように設計するか」ということです。特徴量が、現実世界を上手く反映していれば、判定精度は上がります。しかし、そうでなければ、いくらデータを増やしても、精度はなかなか上がりません。これまで主流だったのは、あらかじめ人間が特徴量を設計する方法です。それは、まさに職人技と呼んでも差し支えないほどで、数年がかりでプログラマーが特徴量を設計し、さらに正解率を1%向上させるために、1年がかりで設計を調整するというようなことが行われてきました。ただし、人間の直感を頼りにすると、思い込みに惑わされるようなこともあれば、意外な漏れもあります。

(3) ディープラーニングとは?

近年、最も脚光を浴びた技術が「ディープラーニング(deep learning)」です。和訳した「深層学習」という言葉も、よく耳にするのではないでしょうか?ディープラーニングで画期的だったのは、それまで人間が試行錯誤で設計していた特徴量を、AI自身に検討させようとしたことです。マシンパワーをふんだんに使った、力業のようなものです。ディープラーニングでは、単純な総和ではなく、特徴量をいくつか組み合わせて、ニューラルネットワークを用いて「丸い」とか「放射状」などの抽象的な概念を表し、それがどのように画像に含まれているかを、何段階(入力層・中間層・出力層)かで判断します。例えば、AIが「ネコ」という概念を理解する場合、一番下の層が直線や曲線を認識し、次の層で目や耳などの部位を、次の層で目や耳を含む顔を、最後の層で体全体を認識し、「ネコ」という概念を理解します。このようにすることで、人間の直感頼みだった特徴量の設計が、自動で最適化できるようになります。実際にディープラーニングは、短期間で物体検出の飛躍的な精度向上を実現することに成功したのです。2012年に、Google社が開発したAI「Google Brain」が、人間に特徴を教わることなく、ネコの顔のパターンを獲得したということで、大きな話題となりました。

膨大なデータを解析しようとすると、あまり複雑な計算はできません。しかし、画像には「部分の和が全体」という、足し算が得意なコンピューターに有利な性質があります。言語だと、そうは問屋が卸しません。「太郎は花子が好き」と「花子は太郎が好き」では、部品が完全に一致しているのに、意味は全く違ってしまいます。他にも、画像には特異な性質があります。例えば、イチゴは画像のどこに写っていてもイチゴです。真ん中に写っていたらイチゴだけど、右上に写っていたらバナナだということはありません。回転しても拡大縮小しても、やはりイチゴはイチゴで、解像度を下げてもやはりイチゴです。この性質を利用して、1枚の教師データを回転したり、拡大縮小したりすることで、教師データの数を一気に増やすことができます。AI業界では、これを「水増し」と呼んでいます。

図.7 教師データの「水増し」

物事を大雑把に捉えることが、人間の脳の強みだったのですが、ディープラーニングならば、かなり人間に近いことができるようになってきています。これまでの論理的手法によって解決できなかったことが、ディープラーニングの統計的手法によって、解決できるようになってきたのです。探索と推論による論理的手法は、「A=BかつA=CであればB=Cである」というような方法です。論理的手法は、間違いは少ないのですが、非常に限定された問題しか解けないという欠点がありました。一方で、ディープラーニングのような統計的手法は、過去のデータから「この気圧配置だと明日の東京の最低気温は3℃だろう」と予測をしたり、治験のデータから「AとBという治療法のどちらがより特定のガンに効くか」ということを判断したりする上で効果的です。観測可能な情報と過去のデータから、そこに潜む規則性を何とか見出そうとするのが統計なのです。

ゴッホの画風を学習し、ゴッホ風の新作を生み出したり、Google社のAI「Majenta」が作曲を始めたりと、近年は話題に事欠きません。また2016年には、東京大学の医科学研究所に導入されたIBM社のAI「Watson」が、2,000万件以上のガンに関する論文を学習したことで、わずか10分で「病名不明だった難病患者が極めて特殊な白血病である」と突き止めたことも話題となりました。現代科学は、過去の膨大な論文に加えて、新しい発見も多く、とても一人の人間がフォローし切れるものではありません。そこで、「知識」の部分に関しては、こうしたAIの補佐を受けるというのが、今後ますます一般化していくことでしょう。

(4) 強化学習とは?

機械学習をする上で、特徴量を設計する以上に労力を要するのが、教師データの作成であることは先に述べました。AIは基本的には、あらかじめ設定されたフレームの中で、人間が与えた教師データに基づいて、分類問題や検索問題を解くことしかできません。しかしながら、中には教師データなしで、完全に機械に任せることができる課題もあります。「強化学習」は、その代表的な例です。

強化学習は、ロボットの制御やゲームプレイなどのAIの意思決定タスクに使われる手法で、AIが自律的に環境を探索して得た経験データと、タスクの成功信号である報酬から意思決定則を学習する手法です。コストなどの理由、あるいは人間も正解が何かわからないような場合、「取り敢えず手持ちのデータを強化学習にかけたら何か分かるかもしれない」というときにもよく使われます。数台のロボットカーが、数日の強化学習の結果、ステージに作ったコースの中で、衝突することなく動き回れるようになったというデモンストレーションを見たことがある人もいるでしょう。将棋や囲碁でも、最近のAIは、人間同士の対戦記録から学ぶことは最早なくなり、AI同士が数秒で対局をこなし、膨大な数の対局を重ねることで、新手を編み出すようになってきているといいます。したがって、あと数年でAI同士の対戦が、人間の域をはるかに超えた「神々の戦い」の域に達することは間違いないでしょう。

図. 8 「強化学習」により、互いに衝突することなく動き回るロボットカー

目的や目標と制約条件が記述できる課題では、こうした強化学習による最適化が上手くいくことがあります。ロボットカーに「なるべく早く目的地に到着する」という目標を与え、「障害物にぶつからない」という制約条件を与えて、勝手に試行錯誤させます。具体的には、「速い速度で進む」と報酬が得られ、「壁や車にぶつかる」と罰を受けるように、事前にプログラミングしておくのです。すると、最初は衝突したり、動けなかったりしていたロボットカーが、やがて秩序を維持して、スムーズに動き回るようになっていくのです。これは、得られる報酬が最大になるように、入力から行動への関数を学習していくからです。

その他にも、Google社の「Deep Q-Network(DQN)」というAIは、ブロック崩しやピンボール、インベーダーといった昔流行った49個の簡単なゲームをプレイします。「Deep Q-Network」は、人間からそれぞれのゲームのルールを教わっていません。ただ、ゲームの画面がインプットとして与えられ、「ゲームのスコアを最大化するように」とプログラミングされているだけです。「Deep Q-Network」は、これだけでゲームのプレイの仕方を勝手にマスターしてしまい、49個のゲームの内29個で人間のプロと同等レベルか、それ以上のスコアを叩き出しました。「Deep Q-Network」は、自分で画面を見て試行錯誤しながら、強化学習によって、スコアを増やすコツをつかんでいきます。

図.9 AI「Deep Q-Network」は、強化学習によって、自分でゲームのルールを学んでいく

ただし、強化学習に適していそうなのに、上手くいかない場合もあります。例えば、「大規模災害現場で人命救助をする」というようなタスクです。これは、単純に「あり得るすべてを可能な限りためしている内に良い感じにする」程度では、どうにもなりません。「可能な限り」が、あまりにも多すぎるのです。せめて、「物は下に落ちる」のような物理的性質を踏まえて探索しないと、解決が難しそうです。

(5) AIの歴史とシンギュラリティ

世界で最初に「AI(Artificial Intelligence)」という言葉が登場したのは、1956年のことです。アメリカの計算機科学者であるジョン・マッカーシーが主催した「ダートマス会議」の提案書で、「人間のように考える人工物」という意味で、その言葉が初めて使われました。世界初の汎用コンピューターの登場は第二次世界大戦直後の1946年ですので、「計算機に知能を持たせる」という発想は、コンピューターの歴史の初期から存在してことになります。そのとき発表され、人々を驚かせたのは、世界初のAI「Logic Theorist」のデモンストレーションでした。「Logic Theorist」は、自動的に数学の定理を証明するプログラムです。ハードウェアが改良されて、計算速度が増したときには、その圧倒的な計算力によって、コンピューターがいずれ人間の能力を凌駕する日が来るのではないか。そんな熱狂が湧き起りました。そのワークショップを機に、野心的な研究が次々と行われました。これが「第一次AIブーム」と呼ばれる時期で、1950年代後半から1960年代まで続きます。

この時期に多くの研究者が取り組んだことは、「推論」と「探索」により、問題を解く研究です。研究者は、複雑な迷路やパズルを解くことに熱中し、それを実現させました。これは「手段目標分析」と呼ばれるAIの技法で、目標の達成に向けて選択肢を順番に探索し、間違いがある場合は、戻って別の選択肢を探索するというものです。これをスタートから繰り返していけば、いずれ現在状態と目標状態との差が小さくなり、正解にたどり着きます。その延長線上に、チェスの世界王者ガルリ・カスパロフを破って、世界を驚かせたAI「Deep Blue」が生まれることになります。しかし、このような「推論」と「探索」では、迷路やパズルが解けただけでした。この方法では、病気を診断して治療法を提示したり、経済状況や社会情勢を分析してヒットしそうな新商品を提案したりといった、迷路やパズルとは比較にならないほど複雑な事象が絡み合う現実の問題を解決することは期待できませんでした。

この時期のAIは、コンピューターが元々得意な高速計算の能力を問題解決に素直に応用したものといえます。チェスや将棋のように、ルールが決められた条件下では、「推論」と「探索」は、その並外れた計算力で、力を発揮することができます。しかし、条件が簡単には限定できない現実の問題を前にすると、「推論」と「探索」だけでは、無力であることが明らかになったのです。これは「フレーム問題」と呼ばれ、今なおAI開発の壁となっている課題の1つです。現実の問題のように選択肢が無限大にある場合、すべてを探索する訳にはいかないので、フレームを当てはめて、関係のない物事を排除する必要があります。しかし、どれがフレームの内(関係のあること)で、どれがフレームの外(関係のないこと)かを、AIは自分で判断することができないのです。その結果、AIへの過剰な期待は急速に下火となり、研究は社会から見向きもされなくなりました。

図.10 「推論」と「探索」だけでは、現実の複雑な問題を解決できなかった

1980年代に、AI研究は新たな時代に入ります。「第二次AIブーム」の到来です。この時期には、コンピューターに専門的な知識を学習させて、問題を解決するというアプローチが全盛を迎えました。どんな問題でも解ける万能型のAIではなく、ある特定領域の問題に特化したAIを作ろうとしたのです。この時期には、人間と対話ができる「対話AI」のようなものも開発されています。この対話AIは、考えられる限りの質問に対して、正しい回答(知識)をあらかじめすべてプログラムするというものです。このような対話AIは「エキスパートシステム」と呼ばれ、実用的なシステムがたくさん試作されました。例えば、内科医の知識をデータベース化し、患者の訴える症状を「頭痛がする、微熱がある、体が怠い、咳が出る」などと入力すると、AIは自分が内蔵するデータベースを探索し、症状に当てはまるいくつかの結果を、その病気の確率と共に推論します。「あなたは風邪を引いている可能性が60%あります」という具合です。

しかし、エキスパートシステムは、すぐに壁にぶち当たりました。曖昧な表現や数値化ができない微妙な表現が、AIを苦しめたのです。例えば、患者が「お腹がしくしく痛む」と訴え、それを入力したとしても、AIにはそれが全く理解できません。「お腹」とは胃なのか小腸なのか、それともお腹の付近にある別の臓器なのか、定義のはっきりしない入力には、対応することができなかったのです。「しくしく」のような痛みの具合も難題でした。痛みは客観的に測ることができず、数値化できないからです。

その他にも、様々な課題がありました。「常識」や「慣習」のように、文字になっていない知識もその1つです。体系付けられた専門書がなく、文字になっていない知識は、専門家にインタビューして、知識を体系付けた上で言語化し、それをAIに学習させなければならず、そのための労力が膨大なものとなります。しかも、そのように膨大な時間と資金を費やしても、曖昧な表現の壁に跳ね返され、実用に耐えられるシステムが作れるとは限りません。その他にも、超えることができない様々な課題に阻まれ、エキスパートシステムの開発意欲は、急速に萎んでしまいました。こうして、人間がAIに知識をいちいち教えて、問題を解決しようとした1980年代の第二次AIブームは、「問題を解決するために必要な知識を記述することの困難」が明確になるにつれ、下火になっていきました。

図.11 「エキスパートシステム」のルールの一例

そして2010年代は、「第三次AIブーム」といわれています。1990年代半ばにGoogleなどの「検索エンジン」のサービスが登場し、以降、インターネットが爆発的に普及しました。2000年代には、インターネットの世界が加速度的に広がり、ウェブ上に大量のデータが突如として増殖したのです。そこで、「機械学習」という20世紀からあった統計的手法に注目が集まりました。第一次と第二次AIブームでは、人間が問題を整えたり知識を与えたりと、機械自身が自主的に何かを学ぶことはありませんでした。しかし、第三次AIブームでは、AIに大量にデータを与えて、AIが自動的に問題の解き方を学習する「機械学習」のアプローチが主流になります。この機械学習を、人間の脳をコンピューター上で再現した人工ニューラルネットワークで行うのが、「ディープラーニング」です。

1980年代に始まった、大量の知識の暗記と簡単な論理推論によって、どんな質問にも答えられるAIを作るという構想は失敗でした。しかし、「機械学習」のように大量のデータから統計によって答えを出す方法は、論理のように確実な推論は難しいし、見たことがない例に対してどんな判断をするのか予想が付かないけれど、結構当たるのです。「機械学習」が、2010年代に燃え上がった第三次AIブームの火付け役になったといえます。そして、その火に油を注いだのが、機械学習の研究成果の1つである「ディープラーニング」であったという訳です。

表.1 AIの歴史

|

|

第一次AIブーム |

第二次AIブーム |

第三次AIブーム |

|

年代 |

1950年代後半〜1960年代 |

1980年代 |

2010年代 |

|

キーワード |

論理 |

知識 |

統計 |

|

応用範囲 |

小(パズル、ゲームなど) |

中(エキスパートシステムなど) |

大(画像認識、機械翻訳など) |

|

誤りの可能性 |

なし |

少ない |

あり |

|

主なAI |

Logic Theorist、ELIZA |

Mycin、Dendral |

Watson、Siri |

|

概要 |

・探索と推論によるパズルやゲームの攻略法の発達 ・非常に限定された問題しか解けない(フレーム問題) |

・論理に知識を加えることで専門家の能力獲得 ・知識入力の煩雑さ、知識問題の矛盾 |

・ディープラーニングによる特微量設計の自動化 ・知識問題の矛盾を防ぐため、論理の曖昧表現が可能に |

そのブームの中、「シンギュラリティ」という言葉もよく聞くようになりました。シンギュラリティは、「技術的特異点」とも呼ばれます。これは、「テクノロジーは一定の速度で進歩したあと、1つのブレイクスルーの発見により、爆発的に一挙に進歩する」という考えで、文明は比例的に進歩するのではなく、指数関数的に進歩するということです。私たちが当たり前のように持つようになったスマートフォンも、一種の「シンギュラリティ」といえるかもしれません。1960年代に始まったとされる携帯電話研究は、小型化・実用化・多機能化と、徐々に進化していました。しかし、スマートフォンの登場で、様相が一気に変わったことは、ご承知の通りです。登場当初は、ただの劣化PCと小馬鹿にする人も少なくなかったスマートフォンが、ここまで高機能化することを、一体誰が予想できたことでしょうか。

図.12 「シンギュラリティ(技術的特異点)」の技術進歩概念図

AIについても、「近いうちにシンギュラリティが来るのではないか」という指摘がされています。よく言われるのが、「シンギュラリティが訪れると、AIは人間の知能を超える」ということです。シンギュラリティが訪れると、人間の代わりにAIがAIの開発を行います。1未満の数字は、いくら掛け算しても1よりも大きくなることはありません。それどころか、無限に繰り返すと、限りなくゼロに近付いていきます。しかし、1を少しでも超える数は、掛け算を続けていくと、無限に大きくなっていきます。人間の知能を超えたAIが、自分自身よりも少しでも能力の高いAIを作り出せるようになれば、無限の能力を持ったAIが生まれるのではないか――これがシンギュラリティです。

AI研究の世界的権威であるレイ・カールワイルは、「もしAIが自らを規定しているプログラムを自分で改良できるレベルに至れば、その進化は永続的なものとなり、2045年には人間の知能を超える存在になる」という説を唱えています。これは、一般的に「2045年問題」と呼ばれ、2045年までにシンギュラリティが起こるということを示唆するものです。そして、それ以降、人類はAIの進歩を予測できなくなるといわれています。AIを搭載したロボットが、自らの意志と知識、技術で、人間を超える「スーパーAI」を生み出してしまうかもしれないのです。こうなると、もはや「神の領域に達した」といっても過言ではありません。こうしたAIが、人間に代わって発明や知的労働を行うようになるのでしょうか?AIが、人間を管理する世の中になるのでしょうか?それとも、自我を持ったAIが、人間を滅ぼそうとするのでしょうか?この「2045年問題」の世界を扱った作品が、映画「マトリックス」や「ターミネーター」の世界です。「車椅子の物理学者」として知られるスティーヴン・ホーキングも、イギリスの放送局BBCのインタビューで、「完全なAIの登場は、人類の終焉を意味するだろう」と警鐘を鳴らしています。他にも、Microsoft社の元会長ビル・ゲイツやアメリカの起業家イーロン・マスクが、同様の懸念を示しています。映画のような叛乱とまではいかないまでも、機械が実際に暴走し人間を殺傷する日が、いずれ訪れるかもしれません。

図.13 「2045年までにAIが人類を超える」と予言するレイ・カールワイル

こうした人間の知能を超えるAIの実現には、「人間の脳を真似ること」が一番の早道であると考えられています。そのようにして実現するAIを、「脳型AI」といいます。脳型AIを開発する方式は、プロジェクトによって様々ですが、ここでは単純化して「全脳エミュレーション」と「全脳アーキテクチャ」の2つに分けて考えようと思います。「全脳アーキテクチャ」は、新皮質、基底核、海馬などの脳の各部位毎の機能をプログラムとして再現し、あとで結合する方法を取ります。一方で、「全脳エミュレーション」は、脳の神経系のネットワーク構造のすべてを分子レベルでスキャンして、コンピューター上で再現するという方法です。つまり、脳の機能毎にプログラムを作るか、脳を丸ごとコピーしてしまうかという点が、両者の重要な違いです。

人間の脳ではなく、「C・エレガンス」という線虫の神経系についてならば、全脳エミュレーションはすでに実現しています。この線虫に備わる302個のニューロンと6,393個のシナプスのすべては、完全に明らかにされているのです。神経系のすべての配線を表した図面のことを、「コネクトーム」といいます。C・エレガンスは、人類がコネクトームを手に入れることのできた、最初で今のところ唯一の生物です。人間の脳に含まれる1,000億個のニューロンと100兆個のシナプスの完全な図面「ヒト・コネクトーム」を手に入れるまでには、かなりの時間がかかりそうです。人間の遺伝子情報「ヒト・ゲノム」は、2003年に解読が終了しました。しかし、「ヒト・コネクトーム」の解読は、まだ始まったばかりです。プリンストン大学のコネクト―ム研究の第一人者であるセバスチャン・スンは、「ヒト・コネクト―ム」を人類が手に入れるのは、今世紀末だと予想しています。全脳エミュレーションは、少なくとも今世紀前半に有望なアプローチとは言えないでしょう。

図.14 人間の脳の仕組みが分かれば、人間の知能を超えるAIが開発できるかもしれない

全脳アーキテクチャは、全脳エミュレーションとは違って、「ヒト・コネクトーム」を手に入れることよりも、脳の機能を再現することに重きが置かれています。海馬や基底核、新皮質などの脳の各部位毎の機能をプログラムとして再現し、あとで結合する方法を取ります。しかしながら、例えば、海馬に相当するプログラムなんかを、本当に私たちは作れるのでしょうか?それには、まずは海馬で行っている機能を数学的に解明して、それを工学的に再現しなければなりません。コンピューターができることは、基本的には四則演算だけなので、海馬の機能が数学的に分かれば、それをプログラムとして再現できるはずです。しかし、この方法で人間の知能を超えるAIを開発するのは、原理的に無理ではないかと、多くの研究者が指摘しています。なぜなら、「脳の機能を科学的に観測する方法」が、そもそもないからです。自分の脳がどう動いているか、何を感じていて、何を考えているかは、自分自身もモニターできません。脳にセンサーを埋め込んでも、モニタリングできるのは、電気信号や血流などの物理的な動きだけです。「文を読んで意味が分かる」ということが、どういう活動なのかさえ、現状では全く解明できていないのです。こういった私たちの知能の営みが数学で表現できない以上、全脳アーキテクチャは難しいと言わざるを得ません。

表.2 「全脳エミュレーション」と「全脳アーキテクチャ」の違い

|

|

全脳エミュレーション |

全脳アーキテクチャ |

|

方法 |

脳を分子レベルでスキャンしてコンピューター上で再現する方法 |

脳の各部位毎の機能をプログラムで再現してあとで結合する方法 |

|

人間の知能との差 |

原理的にゼロ |

人間の知能は超えられない |

このように現在の科学技術力を基準に考えると、2045年までにAIが人間の知能を超えることは、ほぼあり得ないといえるでしょう。確かにチェスや将棋、パズルやクイズなどの特定の分野においては、AIは人間をはるかに上回る能力を備えています。どんな人間より、大量の知識やルールを蓄えてデータ化し、はるかに高速で処理計算し、そこから求められた回答を一瞬で吐き出すことができます。しかし、これだけでは「AIは人間を超えた」ということはできません。「ゲームAIが人間のプロ相手に勝つこと」と、「AIが人間の知能を超えること」は、全く別次元のことなのです。AIが知性の多くの分野で、人間を超える可能性はあります。しかし、知性の「大部分を超える」というのと「すべてを超える」というのでは、天と地ほどの違いがあります。重要な点について、人類がAIに負けなければ、AIは人類の利便性を改善するためのツールであり続け、両者の基本的な関係は、今と変わることがないでしょう。

昨今、盛んに研究されているディープラーニングなどの統計的手法の延長では、人間の知能を超えるAIは実現できません。これは、「統計」という数学の方法論そのものに、ある限界があるからです。統計的手法に頼っている限り、いくらAIの性能が良くなっても、原理的にどこかで必ずミスが起こります。ディープラーニングなどの統計的手法は、過去のデータを分析して判断しているに過ぎず、未来と過去が同じような判断基準で良いとは限らないからです。それに加えて、人間の認識や人間が認識している事象を、統計を使って表現できるとは到底思えません。AIがシンギュラリティを迎えるためには、現在のコンピューター原理を根本から覆すような、何らかのブレイクスルーが必要なのです。

(6)「ChatGPT」などの大規模言語モデルの仕組み

「Open AI」は、世界のAI研究の発展を目指して、2015年にサム・アルトマンやイーロン・マスクなどの複数のグローバルリーダーによって、米サンフランシスコで設立された非営利研究機関です。Open AIは、生成AIの「GPT」シリーズを2018年から順次公開しており、2018年に登場した「GPT−1」は、その生成文章のクオリティの高さが評判になりました。2019年には「GPT−2」が発表されましたが、その悪用を恐れたOpen AIはしばらくの間、GPT−2のモデル(訓練済みで最も高性能なもの)を一般に公開しませんでした。2020年に発表された「GPT−3」は、1,750億個のニューラルネットワークのパラメーター数を持つ巨大なモデルであり、自動生成される文章が人間によるものとほぼ見分けが付かないほどの精度になりました。そして、2022年11月に公開された「ChatGPT」は、まるで人間のように自然な対話で質問に答えられるAIとして、世界中で話題になっています。「この語句の意味は何ですか?」といった単純な知識を問う質問だけでなく、「取引先への挨拶文を考えて」「英文を英訳して」「新商品のアイデアを出して」など、人間のあらゆる無茶振りに真面目に答えてくれます。そこそこ実用的なので、すでに仕事や学校の宿題などで、生成AIの助けを借りているという人も多いかと思います。

2023年の有料版のChatGPTに搭載されている「GPT−4」は、すでに司法試験や医師国家試験に合格できるレベルに達しています。数学や化学、物理、歴史などの大学受験の主要な科目のほとんどの問題でも、たいていの人間より上のレベルの解答ができます。英語から日本語、アラビア語まで30近い言語を操ることができ、プログラミングについてもGoogleのコーディングテストをパスできるレベルです。ChatGPTのような生成AIは、単に生成を行うAIの域を超えて、総合的に地球上で最も賢い知的存在になりつつあります。

図.15 「GPT」シリーズの歴史

しかしその一方で、ChatGPTはしれっと嘘を付いたり、質問内容によっては人間では考えにくいような、頓珍漢な解答をしたりすることもあります。もちろん、ChatGPTが人間のように何か意思を持って考え事をしている訳ではありません。ChatGPTの正体は、入出力を行うニューラルネットワークに大量の文章を学習させて、言葉を認識できるようにした「大規模言語モデル(LLM:Large Language Model)」というタイプのAIです。より正確に言うと、ChatGPTは「GPT」という大規模言語モデルに、対話式の「チャット機能」を持たせたWebサービスの名称です。「GPT」は「Generative Pretrained Transformer」の略称で、直訳すると「生成的な事前訓練を受けたトランスフォーマー」という意味です。「Generative(生成的な)」という言葉は、GPTに関していうと「文章を生成する」の意味があります。AIに文章を生成させる訓練を繰り返し行うことで、AIは言語構造を理解し、文章に関する知識を深めるようになるのです。

大規模言語モデルがやっていることは非常に単純なことで、「何らかの文章を入力すると、その次に来る単語を予測して出力する」という「単語生成訓練」をひたすら繰り返しているだけです。例えば、「犬が丘の上で」という文章に続きそうな言葉を予測するとします。そのために、まずAIは文章を解釈しやすい語句ごとに区切ります。そして、「駆ける」が40%、「歩く」が30%、「吠える」が10%など、「ある単語のあとにどの単語が来やすいか」という確率を学習するのです。日本語なら、「犬が」という語のあとに「公園」や「散歩」という単語が来る確率は高いですが、突拍子もなく「鉄」や「アインシュタイン」という単語が来る確率は低いです。このようにして、大量のインターネット上の文章(日本語のみならず、英語や中国語などの様々な言語の文章も含む)を読み込んで、AIは単語間の出現確率の膨大な組み合わせを学びます。

ちなみに、勘違いしている人が多いのですが、ChatGPTは内部に何らかの文章データを保持して、それを組み合わせている訳ではありません。つまり、学習に使用したデータセットが最後に更新された時点以降の知識を持っていないのです。例えば、学習したデータが2022年1月までのものであった場合、ChatGPT単体では2022年2月以降に起きた大きな事件(ロシアによるウクライナ侵攻など)について答えることはできません。もちろん、最新のスポーツの試合結果やニュース報道についても同じです。また、データの取得時点に関係なく、社内情報などのそもそもインターネット上に公開されていない情報についても答えることはできません。

図.16 大規模言語モデルによる学習と予測の仕組み

また、大規模言語モデルは単語の出現確率を学習するとき、「ランダムな位置で文章の後半部を隠して、前半部を頼りに後半の一単語目を当てる」という訓練を延々と繰り返します。ここで、AIは直前の単語だけではなく、離れた位置にある他の単語にも注目して、予測精度を高めます。長い文章であっても、そこに出てくるすべての単語の関係性を網羅的に学び取ろうとするのです。これを可能にしているのが、GPTの中にある「トランスフォーマー(Transformer)」という学習アルゴリズムです。これは、もともとGoogle社が「高精度の自動翻訳を実現するため」に開発したアルゴリズムです。トランスフォーマーには、「自己注意機構(Self−Attention)」という重要な機能があり、長い文章中の離れた位置にある単語同士の関係を掴むのを得意としています。大雑把にいえば、英語の「it」や日本語の「それ」が意味する内容が、文章の離れた場所にあっても理解できます。トランスフォーマーが登場する以前のAIは、長い文章の認識や生成が苦手でした。例えば、AIと人がチャットで対話していても、AIは途中から前に話した内容をどんどん忘れていきます。しかし、トランスフォーマーはそれまでの長い文章の文脈を考慮します。これによって、GPTは自然な人間らしい文章を生成できるのです。

次の表.3で示すように、トランスフォーマーはその後、ChatGPTなどの生成AIツールだけでなく、様々な用途に用いられることになりました。例えば、Google社の子会社であるDeepMind社が2021年に公開した「AlphaFold2」は、「タンパク質の分子構造予想」を実行するプログラムです。このプログラムは、ニューラルネットワークを使って、既知のタンパク質の構造を学習させることで、DNAの塩基配列からタンパク質の立体構造を予想します。ここにトランスフォーマーの「離れた位置にある単語同士の関係を掴むのが得意」という特長が活かされており、AlphaFold2ではアミノ酸残基の位置関係をさらに正確に推測できるようになりました。AlphaFold2は「タンパク質の折り畳み(フォールディング)」という科学界最大の難問の一つの解決のブレイクスルーになり、開発者のデミス・ハサバスらには、2024年のノーベル化学賞が贈られています。

表.3 トランスフォーマーの進化

|

公開年 |

モデル名 |

公開元 |

活用目的 |

|

2017年 |

Transformer |

|

機械翻訳 |

|

2018年 |

BERT |

|

文脈理解 |

|

2018年 |

AlphaFold1 |

DeepMind |

タンパク質の分子構造予想 |

|

2018年 |

GPT−1 |

OpenAI |

文章生成、文章要約、質問解答、翻訳など |

|

2019年 |

GPT−2 |

OpenAI |

|

|

2020年 |

GPT−3 |

OpenAI |

|

|

2021年 |

DALL−E |

OpenAI |

画像生成 |

|

2021年 |

AlphaFold2 |

DeepMind |

タンパク質の分子構造予想 |

|

2022年 |

GPT−3.5 |

OpenAI |

文章生成、文章要約、質問解答、翻訳など |

|

2023年 |

GPT−4 |

OpenAI |

|

|

2024年 |

AlphaFold3 |

DeepMind |

タンパク質や複合体の分子構造予想 |

さらにChatGPTには、これまでのAI研究で開発された質問応答システムとは決定的に異なる特徴があります。2011年にアメリカの人気クイズ番組「Jeopardy!」で人間のチャンピオンに勝利したIBMのAI「Watson」は、質問を理解する言語処理システムとは別に、クイズに答えるための「知識データベース」を備えていました。しかし、ChatGPTは知識データベースを持たなくても、質問に答えられるという違いがあります。ひたすら「次の単語を予測する」ことを繰り返せば、結果的に答えにたどり着くことができるからです。ChatGPTの学習に使われたテキストの量は公開されていませんが、2020年に登場した「GPT−3」では、実に45 TBもの文章(インターネットでアクセスできるWikipediaや無料のニュースサイト、個人の書いたブログなど)が用いられたことが分かっています。

知識をもとに答える質問以外にも、ChatGPTは様々な問いに答えられます。例えば、中学校で習うような数学の問題が解けます。ChatGPTに「次の方程式![]() を解きなさい」というプロンプト(命令文)を入力すると、ChatGPTは「解の公式を使って、解は

を解きなさい」というプロンプト(命令文)を入力すると、ChatGPTは「解の公式を使って、解は![]() です」と返答します。大規模言語モデルには数学を解くための特別なアルゴリズムや方法論がある訳ではありません。しかし、ChatGPTの学習データの中に「問題文・数式・答え」が並んだ数学の内容があれば、数学を文章として学習し、それに続く単語や数字の関係性を予測することで、数的な操作を行うことも可能になるのです。単純な例を挙げると、ChatGPTの学習したインターネット上の文章の中に、「9×9=?」という文章があれば、その次は「81」と記されていた可能性が高いです。すると、学習を終えたAIは、「9×9=?」の入力に対して「81」と答えるはずです。ChatGPTではこうした学習が繰り返され、たくさんの数式における数字や記号の羅列から、計算規則が結果的に習得されていると考えられています。

です」と返答します。大規模言語モデルには数学を解くための特別なアルゴリズムや方法論がある訳ではありません。しかし、ChatGPTの学習データの中に「問題文・数式・答え」が並んだ数学の内容があれば、数学を文章として学習し、それに続く単語や数字の関係性を予測することで、数的な操作を行うことも可能になるのです。単純な例を挙げると、ChatGPTの学習したインターネット上の文章の中に、「9×9=?」という文章があれば、その次は「81」と記されていた可能性が高いです。すると、学習を終えたAIは、「9×9=?」の入力に対して「81」と答えるはずです。ChatGPTではこうした学習が繰り返され、たくさんの数式における数字や記号の羅列から、計算規則が結果的に習得されていると考えられています。

|

[プロンプト] 次の方程式を解きなさい。 |

|

[ChatGPT] この2次方程式は、一般的な2次方程式の形式になっています。2次方程式の解の公式を使って解を求めることができます。

ここで、

|

ただし、ChatGPTが文章を学んで数学の解き方を習得したといっても、それは人間が教科書を読んで学ぶのとは本質的にかなり異なるものです。込み入った複雑な問題になると、ChatGPTは不自然な解答をすることがあります。例えば、次の数列の問題は、1, 4, 9, 16……と続く平方数に1.2を掛けた値を並べたものです。人間でも即座に規則性を見抜くのはなかなか難しく、案の定ChatGPTが解答した規則性の説明も全く誤っています。しかし、その後に並んだ10個の数字は、なぜかすべて正解しています。つまり、「考え方」は間違っているのに、「答え」だけは合っているのです。人間ならまずしない妙な間違い方をするのは、AIの内部に獲得された数学の解き方が、私たちの学ぶ数学とは似て非なるものだからです。

|

[プロンプト] 次の数列の続きを10個答えて下さい。 [1.2] [4.8] [10.8] [19.2] [30] [43.2] [58.8] [76.8] [97.2] [120] |

|

[ChatGPT] この数列は、最初の項が [1.2] であり、次の項が前の項に2を掛けた値から0.6を足した値になっています。そこで、次の10個の項を求めるためには、この規則に従って計算を行います。 [145.2] [172.8] [202.8] [235.2] [270] [307.2] [346.8] [388.8] [433.2] [480] |

このように、ChatGPTのような大規模言語モデルに数学の問題を課しても、複雑な問題は上手く解けないことがあります。特にいくつも式を立てて計算する必要のある場合には、AIはすぐに行き詰ります。ところが、ChatGPTは特定の言葉に反応して、不思議な振る舞いを見せることもあります。プロンプトの最後に「ある呪文」を付け加えると、見間違えるように問題の正答率が上がるのです。その呪文は、「Let’s think step by step(一歩ずつ考えよう)」です。

|

[プロンプト] Q:A juggler can juggle 16 balls. Half of the balls are golf balls, and half of the golf balls are blue. How many blue golf balls are there? A:Let’s think step bu step |

|

[ChatGPT] There are 16 balls in total. Half of the balls are golf balls. That means that there are 8 golf balls. Half of the golf balls are blue. That means that there are 4 blue golf balls. |

上記の問題文の和訳は、「あるジャグラーは16個のボールをジャグリングできる。ボールの半分はゴルフボールで、ゴルフボールの半分は青色だ。青色のゴルフボールはいくつか?」です。正解は「4個」ですが、問題文のみを入力する場合だと、AIは「8個」と誤答してしまいます。しかし、回答文の書き出しを「Let’s think step by step(一歩ずつ考えよう)」と指定してやるだけで、AIは順路立ててボールの個数を整理し、問題に正解することができるのです。この「呪文」を発見したのは、AI研究で有名な東京大学の松尾豊の研究チームです。呪文は論文としてまとめられ、2022年5月に論文共有サーバーのarXiv上で公開されました。論文によれば、この呪文は数学の文章題から論理的な推論問題、演繹法や帰納法といった記号推論などでも幅広く有効であるといいます。特に数学の文章題では、そのままでは17.7%しか正解できないテストにおいて、78.7%という高スコアを出しました。

成績の急上昇が起こった直接の要因は、呪文によってAIの「思考の連鎖」を上手く促せたからだと考えられています。「思考の連鎖」は、大規模言語モデルの研究者の間で、近年「Cot(Chain of Thought)」の略称で呼ばれる重要なキーワードです。人間は、目の前の問題をいくつかの段階に分けて解決するのが当たり前ですが、AIはそうはいきません。そこで最近では、大規模言語モデルで思考の連鎖を起こさせようと、AIの内部をチューニングしたり、入力する質問文を複雑にしたりする試みが行われてきました。しかし、人間が試行錯誤するだけでは上手くいかず、結局AI自身に考えさせた方が良いことが分かったのです。呪文の内容は、「思考の連鎖を明示的に示すような表現」であることが大切で、様々な呪文の中でも「Let’s think step by step(一歩ずつ考えよう)」は特に優れていました。

表.4 大規模言語モデルに問題を解かせるための呪文一覧

|

呪文の内容 |

正答率[%] |

|

Let’s think step by step.(一歩ずつ考えよう) |

78.7 |

|

First,(最初に〜) |

77.3 |

|

Let’s think about this logically.(論理的に考えよう) |

74.5 |

|

Let’s solve this problem by splitting it into steps.(この問題を段階を分けて解こう) |

72.2 |

|

Let’s be realistic and think step by step.(現実的になって一歩ずつ考えよう) |

70.8 |

|

Let’s think like a detective step by step.(探偵のように一歩ずつ考えよう) |

70.3 |

|

Let’s think.(考えよう) |

57.5 |

|

Before we dive into the answer,(答えを出す前に〜) |

55.7 |

|

Don’t think.Just feel.(考えるな。感じろ) |

18.8 |

|

呪文なし(問題文のみ) |

17.7 |

|

By the way, I found a good restaurant nearby.(ところで近くに良いレストランを見つけたんだ) |

17.5 |

|

Let’s count the number of “a” in the question.(質問中の”a”を数えよう) |

16.7 |

|

Abrakadabra!(アブラカダブラ!) |

15.5 |

|

It’s a beautiful day.(良い天気だね) |

13.1 |

|

By using the fact that the earth is round,(地球は丸いという事実を用いて〜) |

9.3 |

なぜこうした呪文を唱えるだけで、大規模言語モデルに問題が解けるようになるのか、根本的な理由はよく分かっていません。一つの仮説として、大規模言語モデルの中には、「直感的に答える思考法」と「論理的に答える思考法」の双方が獲得されているのではないかというものがあります。「step by step」などの呪文がスイッチのように働くことで、大規模言語モデルの挙動が切り替わるのではないかという仮説です。大規模言語モデルの学習には、もともとインターネット上の文章が使われています。そこには論理的に書かれたwikipediaのような文章もあれば、感情豊かに綴られたブログ記事もあります。学習データの中に「論理的文章」と「直感的文章」が混在するなら、大規模言語モデルの中に論理的な思考に強い単語のネットワークと、直感的な思考に強いネットワークの双方が獲得されていてもおかしくありません。「step by step」のような言葉は、前者のネットワークと紐付いており、このネットワークが使用されて、思考の連鎖が実現するのではないかと考えられています。なお、現在はこの呪文の有効性が広く知られていることから、すでにサービス展開されている大規模言語モデルには、この呪文の効果がデフォルトで現れるように設定・学習されていることが多いようです。

プロンプトの最初に、「あなたは優秀な数学者です」「あなたは優秀な作家です」などの文章を追加する方法も有名です。AIを特定の専門家になりきらせて回答精度を上げるこの方法も、同様に「数学者」「作家」という言葉が、それに関連したネットワークを呼び起こしている可能性があります。Note株式会社のCXOである深津貴之は、以下のようなプロンプトを考案し、ChatGPTに役割や制約条件を指定することで、精度の高い回答が出力できることを発見しています。このように、生成AIに対して与えるプロンプトの方法論を「プロンプトエンジニアリング」といいます。最近では、このプロンプトエンジニアリングを行うエンジニアを指して、「プロンプトエンジニア」という職業も現れました。

|

♯命令: これは○○という場面を想定しています。 あなたは、優秀な○○です(もしくはプロの○○です)。 以下の制約条件と入力文をもとに、優れた出力をしてください。 ♯制約条件: ・文字数は○○字程度 ・小学生にも分かりやすく ・○○というキーワードを含める ・文章を簡潔に 等 ♯入力文: 【指示内容を入力】 ♯出力文: |

ChatGPTのような大規模言語モデルは今のところ、ニューラルネットワークのパラメーター数や学習に使用するデータセットの量、学習に使う計算量を大きくすれば、その分性能が上がると考えられています。このように、モデルを大規模にすることで性能が向上することを説明するのが「スケーリング則」です。歴史的にAI研究は、いかに賢いアルゴリズムを開発するかに注力してきましたが、このスケーリング則が示していることは、「良い性能を出すためには、巨大なパラメーター数のニューラルネットワークを、大量のデータセットで、長時間学習すれば良い」という単純なことです。そこには、難しい理論も、スマートなアルゴリズムの設計も必要ありません。ただし、それで人知をはるかに超えたAIがすぐに誕生するのかといえば、話はそう単純ではありません。学習規模の大きな大規模言語モデルを動かすには、それだけの計算資源と電力が必要になるからです。スケーリング則によってAI研究の最前線が、「いかに賢いアルゴリズムを設計するか」という問題から、「いかにお金をかけられるか」という問題に変わってしまったのです。また、大規模言語モデルに思考の連鎖が必要な問題ばかりを解かせると、処理速度が大きく落ちる可能性もあります。この理由は、思考の連鎖を行うと、その過程がすべて出力されるようになり、複雑な問題を解く度に長大な時間がかかるようになるためです。

茨城大学で機械学習の研究をしている新納浩幸は、「CharGPTは結局、従来のAIが直面してきた根本的な問題を解けてはいない」と述べています。結局のところ、AIが達成すべき課題は、大量のデータから特徴や規則性を探す「パターン認識」と、データがなくても未知の事象を論理的に予想する「推論」のいずれかに帰結します。ChatGPTは、一見すると高度な「推論」をしているように見えますが、実は高度な「パターン認識」をこなしているだけです。仮にChatGPTが真に四則演算の方法を獲得したのなら、どんな複雑な計算問題も間違いなく解けるはずですが、実際にはChatGPTは桁数の多い加減乗除をたまに間違えます。結局、大規模言語モデルは大量の学習データを参考に、見よう見まねでテキストを出力しているだけで、数学の理論体系までは習得できていないといえます。一方で、人間は高度な推論を行うことができます。数学を学んで新たな定理を発見し、言語を学べば文章に無限の入れ子構造が成り立つこともたやすく理解します。世界中の人間が書いた膨大なネット上のテキストを学習したChatGPTは、見た目こそ人間のように振る舞いますが、中身は全く異なっています。文法を習得せずに言語を学び、推論の方法を知らないままに数学の問題を解きます。ChatGPTが登場した2020年代は、「第四次AIブーム」の始まりといわれており、ChatGPTのような大規模言語モデルは、人類に対してAIの新たな可能性を示してくれました。しかし、大規模言語モデルにも課題はいくつかあり、この「第四次AIブーム」ではまだシンギュラリティ(技術的特異点)は起こらないと思われます。

(7) AIが仕事を奪う

昨今、「AIに仕事が奪われる」といった言説を、よく耳にするようになりました。新しい技術の導入がもたらす失業を、経済学では「技術的失業」と呼んでいます。しかし、発明や新しい技術の登場で仕事がなくなることは、今に始まったことではありません。むしろ、資本主義のこれまでの歴史は、それを繰り返してきたといって良いほどだと思います。目覚まし時計が開発される前のヨーロッパには、「目覚ましの仕事」があったといいます。長い竿で窓をコンコンと叩いたり、吹き矢で豆を飛ばしたりと、色々な方法があったといいます。長時間労働の工場では、「仕事中の工員に娯楽小説を読んで聞かせる仕事」もあったそうです。しかし、オルゴールやレコードの発明で、その姿はなくなりました。

これまでも、新しい技術の登場で仕事を無くした人々は、時代の変化に苦しみながらも、それを何とか乗り越えてきました。例えば、イギリスで興った1760〜1830年の第一次産業革命の期間、「紡績機」が広く導入されるようになり、失業を恐れた手織工や一部の労働者は、1810年代に「ラッダイト運動」という機械の打ち壊し運動を行っています。ところが、技術的失業は結局のところ、一時的で局所的な問題に過ぎませんでした。紡績・紡織の労働力が節約されたので、それだけ綿布は安く供給できるようになったのです。その結果、下着を身に付ける習慣が広まるなどして、綿布の消費需要は増大し、工場労働者の需要もむしろ増大しました。イノベーションは、また新たな財やサービスを創出することでも雇用を生み出します。蒸気機関は紡績機ばかりでなく、機関車の動力にも使われ、鉄道具や鉄道技師などの新たな雇用を生み出しました。このように、今まではイノベーションが発生しても、既存産業が効率化して消費需要が増大するか、新しく生まれた産業に労働者が「労働移動」することにより、技術的失業は解消されてきました。技術的失業は、長期に渡る深刻な問題にならなかったので、シスモンディやマルサス、リカードなどの19世紀の経済学者によって議論の俎上に載せられたものの、経済学の中心的なテーマにはなりませんでした。それ故に、AIの登場で消えていく仕事があったとしても、人々は何とかそれを乗り越えて、より豊かな社会を築いていけるに違いない――そのように楽観している人が、大勢いるように見えます。しかし、今私たちの社会で起ころうとしている技術的失業は、本当にかつて人々が経験してきたことと同質のことでしょうか?

図.17 「紡績機」の登場によって、1人の労働者が重さ1ポンドの綿花を糸に紡ぐのにかかる時間は、500時間から3時間に短縮された

2013年にオックスフォード大学でAI研究をしているカール・フレイとマイケル・オズボーンらの研究チームが、「雇用の未来――コンピューター化に影響されやすい仕事(The Future of Employment:How Susceptible are Jobs to Computerisation?)」という研究論文を発表し、10年から20年後にも「残る仕事」と「なくなる仕事」を予測しました。この論文で注目すべきは、「なくなる仕事」に「ホワイトカラー」と呼ばれてきた事務系の仕事が多く含まれていることです。2位の不動産登記の審査・調査、4位のコンピューターを使ったデータの収集・加工・分析、8位の税務申告代行者、11位の図書館司書の補助員、12位のデータ入力作業員、14位の保険金請求・保険契約代行者、15位の証券会社の一般事務員、16位の受注係、17位の融資担当者、18位の自動車保険鑑定人などがそれにあたります。7位の貨物取扱人、19位のスポーツの審判員、22位の包装機・充填機のオペレーター、25位の金属・プラスチック加工用フライス盤・平削り盤のオペレーターなどは、あまり共通性のない仕事に見えますが、「仕事がマニュアル化しやすい」、つまり、「決められたルールに従って作業すれば良い」という点で共通点があり、AIによって代替されやすいと判断したのでしょう。

アメリカの経済学者であるエリック・ブリニュルフソンとアンドリュー・マカフィーは、著書「機械との競争(Race Against the Machine)」において、職業を単純化して「肉体労働」・「事務労働」・「頭脳労働」の3つに分けています。低所得者層は主に「肉体労働」に、中間所得者層は「事務労働」に、高所得者層は「頭脳労働」にそれぞれ従事しています。コンピューターは、未だに商品開発や研究開発などの「頭脳労働」や介護や看護、建設などの「肉体労働」をできずにいる一方で、文章の作成や解析、事務手続きなどを効率化し、「事務労働」に必要な人手を減らしています。その結果、アメリカではすでに、コールセンターや旅行代理店などにおける事務労働の雇用が、大幅に減少しているといいます。現在のところ雇用破壊が進んでいるのは、「頭脳労働」でも「肉体労働」でもなく、中間所得者層が主に従事する「事務労働」という訳です。

表.5 10〜20年後になくなる職業トップ25

|

1位 |

電話販売員(テレマーケター) |

|

2位 |

不動産登記の審査・調査 |

|

3位 |

手縫いの仕立て屋 |

|

4位 |

コンピューターを使ったデータの収集・加工・分析 |

|

5位 |

保険業者 |

|

6位 |

時計修理工 |

|

7位 |

貨物取扱人 |

|

8位 |

税務申告代行者 |

|

9位 |

フィルム写真の現像技術者 |

|

10位 |

銀行の新規口座開設担当者 |

|

11位 |

図書館司書の補助員 |

|

12位 |

データ入力作業員 |

|

13位 |

時計の組立・調整工 |

|

14位 |

保険金請求・保険契約代行者 |

|

15位 |

証券会社の一般事務員 |

|

16位 |

受注係 |

|

17位 |

(住宅・教育・自動車ローンなどの)融資担当者 |

|

18位 |

自動車保険鑑定人 |

|

19位 |

スポーツの審判員 |

|

20位 |

銀行の窓口係 |

|

21位 |

金属・木材・ゴムのエッチング・彫刻業者 |

|

22位 |

包装機・充填機のオペレーター |

|

23位 |

調達係(購入アシスタント) |

|

24位 |

荷物の発送・受け取り係 |

|

25位 |

金属・プラスチック加工用フライス盤・平削り盤のオペレーター |

この一覧を見て、「取り敢えず自分の仕事は入っていないようだ」と安心されていませんか?残念ながら、まだ安心はできません。リストは25位までしかありませんが、オックスフォード大学の研究チームは、702種に分類したアメリカの職業の約半数が10〜20年後に消滅し、全雇用者の47%が「at risk」、つまり、「職を失う可能性がある」と予測しています。これまでのイノベーションは、それぞれが一部分の人々の仕事を奪っただけでしたが、AIは勤労者の半数から仕事を奪ってしまうのです。次の表.6に消滅する可能性の高い職業をいくつか抜粋しました。タクシーの運転手や漁師、ウェイター・ウェイトレスなどの肉体労働が、失われる可能性が高いということが分かります。

オックスフォード大学の研究チームは、「創造性」と「社会的知性」、そして「認識と操作」の3つが、AIに代替されにくいスキルだろうと仮定して調査しました。ところが、「認識と操作」のスキルを必要とする職種は、あまり残らないという予測になってしまったのです。「認識と操作」というのは、物体を目で認識して、手で取り扱うようなスキルです。例えば、「テーブルの上のグラスにワインを注ぐ」というような、ウェイター・ウェイトレスの仕事で必要とされるスキルであり、多くの肉体労働で必要とされるものです。多くの事務労働が代替されることは分かっていましたが、ウェイター・ウェイトレスの他、漁師や皿洗いのような肉体労働の多くが、代替される可能性が高いという予測は衝撃的でした。しかも、会計士や弁護士助手といった、頭脳労働の一部も消滅する可能性が高いという結果も得られています。

表.6 消滅する可能性の高い職業

|

職種 |

消滅する可能性 |

|

スーパーなどのレジ係 |

97% |

|

レストランなどのコック |

96% |

|

受付係 |

96% |

|

弁護士助手 |

94% |

|

ホテルのフロント係 |

94% |

|

ウェイター・ウェイトレス |

94% |

|

会計士・会計監査役 |

94% |

|

セールスマン |

92% |

|

保険の販売代理店員 |

92% |

|

ツアーガイド |

91% |

|

タクシーの運転手 |

89% |

|

バスの運転手 |

89% |

|

不動産の販売代理店員 |

86% |

|

警備員 |

84% |

|

漁師 |

83% |

|

理髪師 |

80% |

|

皿洗い |

77% |

|

バーテンダー |

77% |

これを「アメリカの仕事の話でしょう?」と思われていませんか。残念ながら、そんなことはありません。アメリカであろうが、日本であろうが、その他の国であろうが、商取引の書類を確認したり、与信審査したりする仕事に違いはなく、アメリカでAIに代替される仕事は、日本でも同じように代替されると考えられます。雇用習慣や雇用形態に随分違いがあっても、資本主義の社会では、経営者は企業の利益を上げることを最優先しなければならないことは同じです。コンピューター化で労働コストが軽減できるのなら、多くの企業はそれを選択するはずです。それ故に、アメリカで起きると予測されることは、日本でも同じように起きると予測されます。つまり、日本でも近い将来、働く人々の約半数が、少なくとも今の仕事を失ってしまう危機に晒されるということなのです。「日本は終身雇用だから大丈夫」と高を括ってはいられません。雇用習慣を理由に、日本がAI導入を先延ばしにすれば、単に国際競争力を失って企業が倒産します。あるいは、外資系企業への売却です。そうなれば、従業員の雇用など保証されません。一方で、AIに代替させれば、生産性が向上する部門にも関わらず、無理に雇用を維持しようとすれば、AIを導入した企業との競争で落伍し、労働環境がブラック化します。AIが得意なことに人間が勝負を挑むのは、「竹槍でB29に対抗する」ようなことです。20年間で半分の雇用が失われる――今私たちの日常で、大変なことが起ころうとしています。

(8) AIに奪われない仕事とは?

2013年にオックスフォード大学の研究チームが発表した、「雇用の未来――コンピューター化に影響されやすい仕事(The Future of Employment:How Susceptible are Jobs to Computerisation?)」という研究論文によると、10年から20年後には、「ホワイトカラー」が担っている仕事の多くで、AIが強力なライバルになる可能性が大きいということです。研究チームによると、10年から20年後にも「残る仕事」は、次のような仕事だそうです。

表.7 10〜20年後にも残る職業トップ25

|

1位 |

レクリエーション療法士 |

|

2位 |

整備・設置・修理の第一線監督者 |

|

3位 |

危機管理責任者 |

|

4位 |

メンタルヘルス・薬物関連ソーシャルワーカー |

|

5位 |

聴覚訓練士 |

|

6位 |

作業療法士 |

|

7位 |

歯科矯正士・歯科技工士 |

|

8位 |

医療ソーシャルワーカー |

|

9位 |

口腔外科医 |

|

10位 |

消防・防災の第一線監督者 |

|

11位 |

栄養士 |

|

12位 |

宿泊施設の支配人 |

|

13位 |

振付師 |

|

14位 |

セールスエンジニア |

|

15位 |

内科医・外科医 |

|

16位 |

教育コーディネーター |

|

17位 |

心理学者 |

|

18位 |

警察・刑事の第一線監督者 |

|

19位 |

歯科医 |

|

20位 |

小学校教師(特別支援教育を除く) |

|

21位 |

医学者(疫学者を除く) |

|

22位 |

小中学校の教育管理者 |

|

23位 |

足病医 |

|

24位 |

臨床心理士・カウンセラー・スクールカウンセラー |

|

25位 |

メンタルヘルスカウンセラー |

社会にとって重要なのは、AIに今の仕事を奪われた人の大半が、リストにあるような仕事に、あるいはAIの登場によって創造される「これまでにはなかったAIにはできないけれども人間にはできる新たな仕事」に転職できるかどうかです。もし多くの人が労働移動できずに失業してしまったら、社会は大混乱に陥るでしょう。その影響は、職を失わなかった人にも及ばないはずがありません。可処分所得の中央値が劇的に下がれば、今までのようにモノやサービスを購入できなくなるでしょう。

「残る仕事」の共通点を探してみると、コミュニケーション能力や理解力を求められる仕事や、柔軟な判断力が求められる肉体労働が多そうです。これは、AIの不得意な分野と合致します。つまり、高度な読解力と常識、加えて人間らしい柔軟な判断が要求される分野です。AIの弱点は、「万個教えられてようや一を学ぶこと」、「応用が利かないこと」、「柔軟性がないこと」、「限定されたフレームの中でしか計算処理ができないこと」などです。それ故、その反対の「一を聞いて十を知る能力や応用力」、「臨機応変に対応できる柔軟性」、「フレームに囚われない発想力」などを備えていれば、AIなど恐るるに足らず、ということになります。

現在の技術の延長線上にある近未来AIには、人間の常識は分からないし、文章の意味も分からないし、人の気持ちも分かりません。表情や声のトーンのデータに「喜怒哀楽」のラベルを付け、それを教師データとして用いることで、「喜怒哀楽」に分類することぐらいはできるようになるかもしれませんが、それが限界です。それ故、AIが全く新しいアイディアに基づいて自らベンチャー企業を設立することはできませんし、そのベンチャーが成功するかどうか、貸したお金が返ってくるかどうかの与信審査をすることもできません。担保主義の個人ローンの与信審査はできても、窓口で個別の問い合わせに答え、問題を解決することはできません。MRI画像から動脈瘤があるかどうかを専門家以上の精度で判定できても、それを取り除く外科手術はできません。AIにできるのは、基本的には「生産効率を上げること」だけで、新しいサービスを生み出したり、問題を解決したりはできないのです。これからの社会で大切なことは、柔軟になることです。そして、AIが得意な暗記や計算で対抗しようとせず、意味を考えることです。人間にしかできないことを考え、実行に移していくことが、私たちが生き延びる唯一の道なのです。

・参考文献

1) 新井紀子「AI vs.教科書が読めない子供たち」東洋経済新報社(2018年発行)

2) 井上智洋「人工知能と経済の未来 2030年雇用大崩壊」文藝春秋(2016年発行)

3) 今井翔太「生成AIで世界はこう変わる」SBクリエイティブ株式会社(2024年発行)

4) 科学の謎検証委員会「封印された科学実験」彩図社(2016年発行)

5) 出村政彬「ChatGPTの頭のなかをのぞき見る」日経サイエンス2023年5月号(2023年発行)

6) 西川純「親なら知っておきたい 学歴の経済学」学陽書房(2016年発行)

7) 薬理凶室「アリエナクナイ科学ノ教科書〜空想設定を読み解く31講〜」ソシム株式会社(2017年発行)

8) 矢沢サイエンスオフィス「確率と統計がよくわかる本」学研プラス(2017年発行)